ファインチューニングとは?手順や他の学習方法の違いについて解説

生成AIや大規模言語モデル(LLM)の発展により、AI活用の幅は急速に広がっています。

その中で「ファインチューニング」という技術は、既存のモデルを特定の用途やドメインに適応させる方法として注目されています。

一般的なAIモデルは幅広い知識を持ちますが、特定の業務や専門分野における精度を高めるためには追加の学習が必要です。ファインチューニングを実施することで、モデルはより目的に即した出力を生成できるようになります。

本記事では、ファインチューニングの概要、具体的な手順、他の学習方法との違い、メリットとデメリットをわかりやすく解説します。エンジニアにとって実務に直結する内容となっていますので、ぜひ最後までご覧ください。

目次

ロボット工学技術者・ロボットエンジニアとは?

ファインチューニングの概念を理解する前に、まず「ロボット工学技術者(ロボットエンジニア)」という職種を例にとって考えてみましょう。

ロボット工学技術者は、機械、電気、情報処理といった幅広い分野の知識を組み合わせてロボットを設計・開発する専門家です。

ロボットは「骨格」「神経」「感覚」「脳」「筋肉」といった人間の身体機能を模した複合システムで構成されており、それぞれを担当するエンジニアが協力して一体のシステムを作り上げます。

この構造は、AIモデルの開発・チューニングにも通じています。AIモデルは大規模に学習済みの「全体像」を持ちながら、特定の領域に合わせて調整することで実用性が高まります。ロボットが用途に応じて部品や制御方法を最適化するのと同じように、AIモデルもファインチューニングによって精度を引き上げることが可能です。

したがって、ロボット工学技術者の役割を理解することは、ファインチューニングの必要性をイメージするうえで有用な比喩となります。

ロボット工学技術者・ロボットエンジニアの仕事内容

ロボット工学技術者の仕事は、ロボットを構成する複数の要素を設計・開発し、それらを統合して機能するシステムを構築することです。

ロボットは人間の身体を模して設計されることが多く、それぞれの要素に対応するエンジニアが専門性を発揮します。

ここでは、主要な担当分野を5つに分けて解説します。

メカ系(骨格・ボディ担当)

メカ系エンジニアは、ロボットの骨格や外装、関節構造といった「身体の骨組み」にあたる部分を担当します。設計段階では、強度や耐久性を確保しながらも軽量化を図ることが重要です。

また、用途に応じて人型、アーム型、移動型など最適な形状を設計します。材料工学や機械設計の知識が求められる領域です。

エレキ系(神経・循環器担当)

エレキ系エンジニアは、電気回路や通信機能を担当し、ロボットの「神経系」として信号を伝達する役割を担います。

モーター制御、センサー信号の処理、電源供給などを設計し、システム全体を円滑に動作させます。安定した電力管理と効率的な配線設計は、ロボットの信頼性に直結します。

センサ系(五感担当)

センサ系エンジニアは、ロボットの「五感」に相当する部分を設計します。

カメラ、マイク、加速度センサ、温度センサなど、多様なセンサを搭載し、環境情報を正確に取得することが役割です。

近年はAIによる画像認識や音声認識と連携することで、高度な判断を可能にしています。

知能・制御系(大脳・小脳担当)

知能・制御系エンジニアは、ロボットの「脳」にあたる部分を担当します。

センサから得られた情報を解析し、最適な行動を判断する制御アルゴリズムを設計します。

AIや機械学習技術を取り入れることで、自律的な動作や高度な意思決定が可能になります。ロボットの知能レベルは、この領域の設計に大きく依存します。

駆動系(筋肉・手足担当)

駆動系エンジニアは、ロボットの「筋肉」に相当する部分を担当し、モーターやアクチュエータを設計・制御します。

滑らかな動作や高精度な位置制御を実現するためには、力学的な知識や制御工学が欠かせません。用途によっては人間と共同作業を行うため、安全性や協調性を重視した設計も必要です。

このように、ロボット工学技術者は多様な専門分野の集合体であり、互いに連携することでロボットという一つのシステムを完成させています。

ファインチューニングとは

ファインチューニングとは、既に学習済みの大規模モデル(事前学習モデル)に対して追加の学習を行い、特定のタスクやドメインに最適化する手法を指します。英語では「Fine-Tuning」と呼ばれ、自然言語処理(NLP)や画像認識、音声認識など幅広い分野で利用されています。

大規模言語モデル(LLM)は一般的な知識を網羅的に持っていますが、そのままでは特定業界の専門知識や固有の業務フローに十分対応できない場合があります。

例えば、法律分野では条文や判例の専門用語を正しく解釈する必要があり、医療分野では疾患名や治療方法を正確に扱う必要があります。

こうしたニーズに対応するために、ドメイン固有のデータを追加学習させ、モデルを特化させるのがファインチューニングです。

また、ゼロからモデルを学習させる場合には膨大な計算資源や時間が必要ですが、ファインチューニングは既存モデルを基盤として活用するため、効率的に高精度なモデルを構築できるのも大きな特徴です。

エンジニアにとって、ファインチューニングは「汎用モデルを自分たちの業務に合わせて最適化するための必須スキル」といえるでしょう。

ファインチューニングの手順

ファインチューニングは、既存のモデルを特定タスクに適応させるプロセスであり、計画的に進める必要があります。ここでは、エンジニアが実際に取り組む際の流れを6つのステップに分けて解説します。

1.目的のタスクに合ったモデルを選ぶ

最初のステップは、目的に適した事前学習モデルを選ぶことです。一般的な自然言語処理であればBERTやGPT、画像認識ならResNetやVision Transformerなどが候補になります。

重要なのは、タスクに必要な表現力やモデルサイズを見極めることです。過剰に大きなモデルを選ぶと計算コストが増大するため、リソースと精度のバランスを考慮して選定します。

2.データセットの準備

次に、対象タスクに合わせたデータセットを収集・整備します。入力と出力が明確に定義された高品質なデータが不可欠です。

例えば、テキスト分類ではラベル付きデータ、対話モデルではユーザー質問と回答のペアが必要となります。データクリーニングや正規化を行い、学習に適した形式に加工する工程も欠かせません。

3.学習環境の構築

ファインチューニングを実行するには、GPUやTPU*などの計算リソースを備えた学習環境が必要です。

クラウドサービスを利用すれば、初期投資を抑えつつ高性能環境を構築できます。PythonやPyTorch、TensorFlowなどのフレームワークも準備し、再現性の高い環境設定を行うことが重要です。

*Tensor Processing Unit(テンソル処理ユニット) の略で、Google が開発した 機械学習向け専用プロセッサのことで行列計算やテンソル演算に最適化されている。

4.ハイパーパラメータの設定

学習率(Learning Rate)、バッチサイズ、エポック数*といったハイパーパラメータを適切に設定します。

これらは学習の安定性や収束速度に直結するため、グリッドサーチやベイズ最適化などを活用して調整することが推奨されます。

特に学習率は大きすぎると収束しない、小さすぎると過学習や計算コスト増に繋がるため慎重な設定が求められます。

*学習率はモデルが誤差をどの程度のステップで修正するかを決める値。バッチサイズ一度の学習で処理するデータの数。エポック数はデータセット全体を何回繰り返して学習するかを決める回数を夫々表す。

5.トレーニングの実行

環境とデータが整ったら、実際にモデルを学習させます。事前学習済みの重みを初期値として利用し、追加データに基づいて最適化を行います。

この際、過学習を防ぐためにドロップアウトや正則化を活用することが一般的です。学習過程では、検証データを用いた性能モニタリングを並行して行い、最適なモデルを選択します。

6.モデルの評価

最後に、テストデータを用いてモデルの性能を評価します。

精度(Accuracy)、適合率(Precision)、再現率(Recall)、F1スコアなど、タスクに応じた指標を確認することが重要です。必要に応じて誤分類分析やエラーパターンの特定を行い、改善点を次のサイクルに反映します。

この6つの手順を踏むことで、目的に即した高精度なモデルを効率よく構築できます。

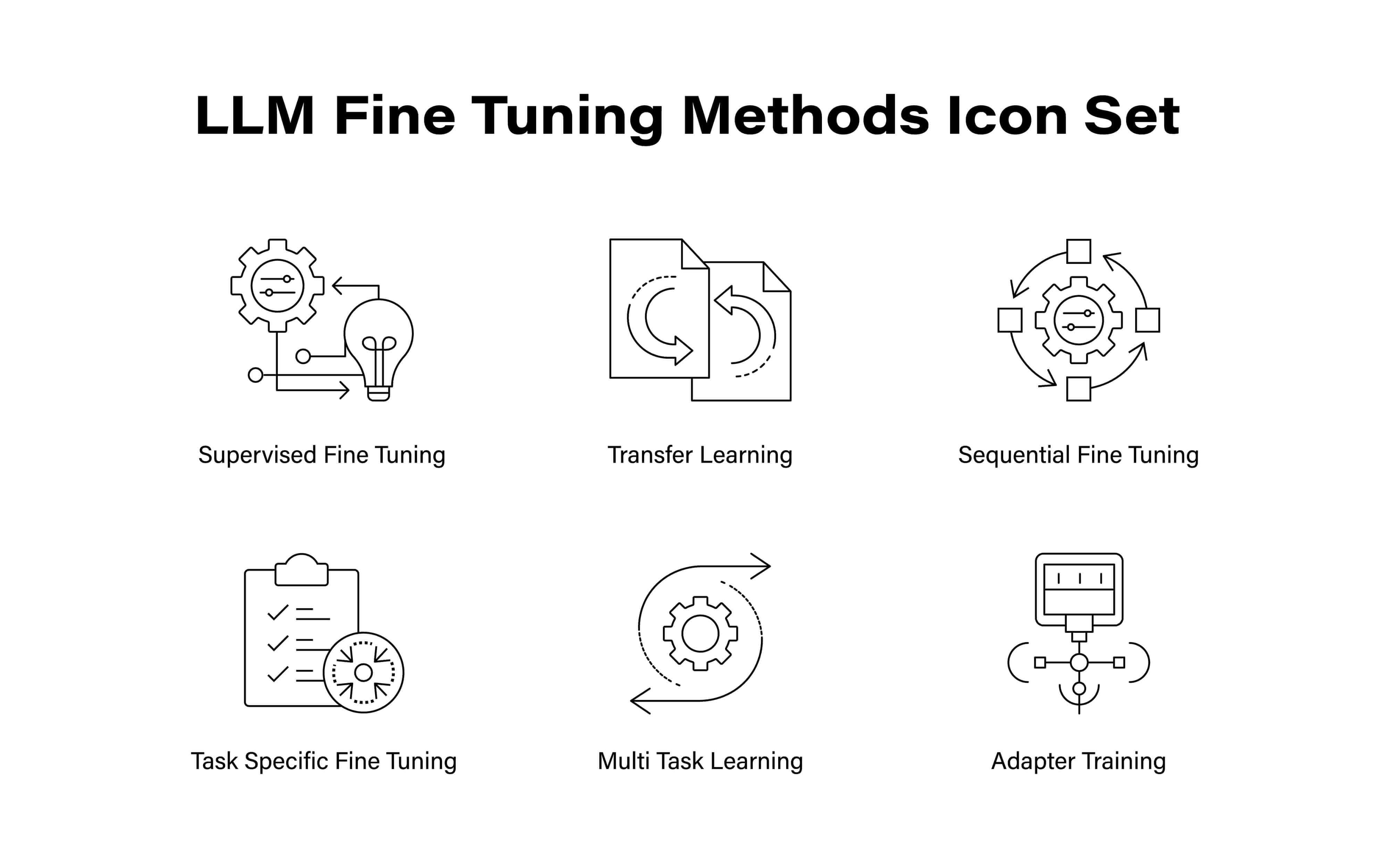

ファインチューニングと他の学習方法の違い

ファインチューニングは強力なモデル適応手法ですが、それ以外にもAI分野ではさまざまな学習方法が存在します。

ここでは、ファインチューニングと混同されやすい代表的な手法と比較し、それぞれの違いを整理します。

ファインチューニングと転移学習の違い

転移学習とは、あるタスクで学習したモデルを別のタスクに応用する手法です。

ファインチューニングは転移学習の一種であり、追加のデータを用いてモデルをさらに学習させる点が特徴です。

つまり、転移学習は知識の再利用全般を指す広い概念であり、その中で特にモデルの重みを調整してタスクに適応させる方法がファインチューニングといえます。

ファインチューニングとRAGの違い

RAG(Retrieval-Augmented Generation:検索拡張生成)は、学習済みモデルに外部データ検索を組み合わせることで精度を高める手法です。

RAGは追加学習を必要とせず、リアルタイムに外部知識を取り込める点が特徴です。

一方、ファインチューニングはモデルそのものを更新するアプローチであり、学習データに依存します。最新情報や動的データを扱うならRAG、特定領域に特化した高精度モデルを構築したいならファインチューニングが適しています。

ファインチューニングと強化学習の違い

強化学習は、エージェントが環境との相互作用を通じて報酬を最大化する行動を学習する方法です。

ゲームAIやロボット制御などに活用されます。ファインチューニングは過去データを使った教師あり学習に基づくのに対し、強化学習は試行錯誤を通じて戦略を発見する点が異なります。

近年では、大規模言語モデルに強化学習を組み合わせた「RLHF(人間のフィードバックによる強化学習)」が注目されており、ファインチューニングとは補完関係にあります。

ファインチューニングとインストラクションチューニングの違い

インストラクションチューニングは、ユーザーの指示(プロンプト)に従った応答を最適化するための学習方法です。

具体的には、タスク指示と期待される出力のペアを学習させることで、モデルが自然言語の指示に従う能力を高めます。

ファインチューニングが特定のドメインやタスクに特化させるのに対し、インストラクションチューニングは幅広い指示に柔軟に応じられるモデルを作ることを目的としています。

両者を組み合わせることで、より実用的で高性能なモデルを構築できます。

ファインチューニングのメリット

ファインチューニングは、大規模言語モデルや画像認識モデルを特定の用途に適応させるために広く利用されており、多くの実務的なメリットがあります。ここでは代表的な3つのメリットを解説します。

パフォーマンスの向上

ファインチューニングを行うことで、モデルは対象タスクに必要な知識や表現を強化でき、精度の向上が期待できます。

例えば、医療分野の診断支援モデルに医学論文やカルテ情報を追加学習させれば、一般的なモデルよりも専門性の高い判断を行えるようになります。汎用モデルでは限界があるケースでも、ファインチューニングによって特化型モデルへと進化させられるのです。

計算リソースの削減

ゼロから大規模モデルを学習させる場合、膨大な計算資源と時間が必要になります。ファインチューニングは既存のモデルを活用するため、新規学習と比べて必要な計算量を大幅に削減できます。

これにより、限られたGPUリソースやクラウド利用料金であっても、高品質なモデルを短期間で構築可能です。効率性を重視する企業や研究者にとって、大きな利点となります。

迅速な適応

市場や業務の変化に合わせてモデルをすばやく調整できる点もメリットです。

例えば、新しい商品カテゴリが追加された場合や、新しい法規制が施行された場合でも、追加データを用いてファインチューニングを行うことで、短期間で対応可能となります。

既存モデルの柔軟性を活かして迅速に適応できる点は、競争力を維持するうえで大きな強みです。

ファインチューニングのデメリット

ファインチューニングは多くの利点を持つ一方で、導入や運用にあたって注意すべき課題も存在します。メリットだけに注目してしまうと、実務におけるリスクを見落としかねません。ここでは代表的なデメリットを3つ解説します。

学習内容に過剰反応するおそれがある

ファインチューニングは特定のデータを強調して学習させるため、過学習(オーバーフィッティング)が発生しやすい傾向があります。

例えば、特定業界の専門用語を強く学習させすぎると、汎用性が低下し、一般的な入力に対して不適切な応答を返すリスクがあります。学習データのバランスや正則化手法を工夫し、過剰適応を防ぐ仕組みが必要です。

ハイパーパラメータの選択が難しい

学習率やエポック数、凍結層の範囲といったハイパーパラメータは、モデルの性能に大きな影響を与えます。

しかし、最適な値を見つけるのは容易ではなく、試行錯誤を繰り返す必要があります。特にリソースが限られている環境では、最適化に時間とコストがかかる点が課題となります。

アップデートで再学習を求められる

ファインチューニングを行ったモデルは、その学習時点のデータに最適化されているため、外部環境の変化に対応できないことがあります。

新しい法律や技術トレンド、製品情報が登場した場合には、再度ファインチューニングを行う必要があり、その都度リソースやコストが発生します。動的な情報を扱う用途では、更新頻度をどう設計するかが大きな課題となります。

ファインチューニングの精度を高めるには

ファインチューニングは、単純にモデルに追加データを与えて学習させれば精度が向上するというものではありません。

むしろ、戦略的な工夫を取り入れることで大幅に性能を改善できます。学習データの整備方法やハイパーパラメータの設定、学習する層の選択、さらには最新の手法の導入まで、さまざまな工夫が有効です。

ここでは、エンジニアが実務で精度を高めるために意識すべき具体的なアプローチを詳しく解説します。

学習の土台を最適化する

ファインチューニングの成果は、基盤となるモデルと学習データの品質に大きく左右されます。基盤がしっかりしていなければ、その上にどれだけ工夫を加えても精度は頭打ちになってしまいます。

そのため、まずは「どのモデルをベースにするか」「どのようなデータを用意するか」を徹底的に吟味することが重要です。

指示チューニングとフォーマットを徹底する

学習データは単に数が多ければよいのではなく、一貫性と明確さが求められます。入力(プロンプト)と出力(期待される応答)の形式を統一することで、モデルはパターンを認識しやすくなり、誤学習を防げます。

特に自然言語処理タスクでは、曖昧な指示を避け、明示的なタスク指示を組み込む「インストラクションチューニング」を取り入れることが効果的です。これにより、ユーザーの多様な問いかけに対して柔軟に応答できるようになり、実運用での利便性が大幅に向上します。

学習率(Learning Rate)を調整する

学習率は、モデルがどの程度の速さで最適化されるかを決める重要なパラメータです。値が大きすぎれば収束せず、学習が暴走してしまいます。

逆に小さすぎれば学習が停滞し、時間と計算資源を浪費することになります。

そのため、ウォームアップスケジュール*で学習初期は小さく始めて徐々に大きくする、あるいはコサインアニーリング*で段階的に学習率を下げるといった工夫が推奨されます。こうした調整により、過学習を防ぎながら効率的に最適解へ近づけます。

*ウォームアップスケジュール、コサインアニーリングは学習率の調整手法。

学習する層を戦略的に選ぶ

モデル全体を無条件に学習させるのは必ずしも効率的ではありません。必要な層を選んで調整することで、リソースを節約しつつ精度を高めることが可能です。

凍結層(Frozen Layers)を調整する

一般に、モデルの初期層は普遍的な特徴(文法パターンや基本的な画像エッジ検出など)を抽出します。

これらは多くのタスクで再利用できるため、凍結してそのまま利用するのが効率的です。

一方、タスク固有の知識を必要とする中間層や後半層は積極的に学習させることで、精度の向上に繋がります。この層による学習戦略は、計算コストの削減と性能改善を両立させる重要なポイントです。

REFTを導入する

REFT(Representation Fine-Tuning)は、既存の表現空間を効率的に調整するアプローチです。

特徴量表現の部分的な改良にフォーカスするため、従来よりも少ない計算リソースで効果的な精度向上が可能です。大規模な追加学習を行わずに性能改善を実現できる点から、限られたGPU環境やコストを抑えたい現場で注目されています。

LoRAを適用する

LoRA(Low-Rank Adaptation)は、モデル全体のパラメータを更新するのではなく、低ランク行列を追加学習することで効率的にファインチューニングを実現する手法です。

これにより、学習させるパラメータ数を大幅に削減でき、軽量かつ高速な学習が可能になります。LoRAは学習済みモデルの汎用性を保ちながらタスク特化を行えるため、研究開発から企業システムまで幅広い利用が広がっています。

まとめ

ファインチューニングとは、既存の大規模モデルに追加学習を行い、特定のタスクや業務領域に適応させる技術です。

ゼロからモデルを構築するよりも効率的に高精度な成果を得られる点が特徴であり、実務に直結するAI活用の中核を担う存在といえます。

手順としては「モデル選定」「データ準備」「学習環境の構築」「ハイパーパラメータ設定」「トレーニング」「評価」という流れが一般的で、適切に進めることで高い成果を発揮できます。

また、転移学習・RAG・強化学習・インストラクションチューニングといった他の学習方法と比較することで、ファインチューニングの位置づけや有効な活用シーンが明確になります。

精度を高めるためには、学習データの整備や学習層の選択、さらにLoRAやREFTなどの最新手法を取り入れる工夫も欠かせません。

一方で、過学習やハイパーパラメータ調整の難しさ、再学習コストといったデメリットも存在するため、導入に際しては長期的な運用戦略を考えることが大切です。

ファインチューニングは、生成AIをより実用的かつ信頼できる形に進化させる重要な技術です。これからAI活用を進めたいエンジニアや企業にとって、理解しておくべき必須知識といえるでしょう。

AI・データ関連の最新案件を探すなら、BIG DATA NAVI への登録がおすすめです。豊富な案件情報から自分に合ったプロジェクトを見つけ、スキルを活かせるチャンスを広げましょう。

AIを仕事にするためのキャリアノウハウ、機械学習・AIに関するTopics、フリーランス向けお役立ち情報を投稿します。

フリーランス求人を探す

フリーランス求人を探す