生成AIにおけるLoRAとは?仕組みや作成方法・導入方法について解説

画像生成AIや大規模言語モデル(LLM)の普及に伴い、特定のキャラクターや画風、専門知識を効率的に学習させる手法として「LoRA(Low-Rank Adaptation)」が注目を集めています。

従来の学習手法に比べてコストや時間を大幅に抑えられるため、個人クリエイターから企業まで幅広く活用されています。

しかし中には、「LoRAとは何か」「ファインチューニングとどう違うのか」といった疑問を持つ方もいらっしゃると思います。

本記事では、LoRAの基本概念から仕組み、メリット・デメリット、作成手順や導入方法、業界別の活用事例までを体系的に解説します。

目次

LoRAとは

LoRA(Low-Rank Adaptation)とは、2021年にMicrosoftの研究者らによって提案された、巨大なパラメータを持つ既存のAIモデルに対して、特定の要素を効率的に追加学習させるための手法です。

従来のファインチューニングはモデル全体の膨大なパラメータを更新するため多大な計算資源を必要としますが、LoRAはモデルの一部に「アダプタ」と呼ばれる小さな層を挿入し、そこだけを学習させます。

これにより、元のモデルの性能を維持したまま、特定のスタイルや知識を短時間で習得させることが可能です。

LoRAの仕組み

LoRAの仕組みは、既存モデルの重み行列を直接変更せず、低ランク行列を追加する形で学習する点にあります。

AIモデルの学習は巨大な「重み行列」を更新する作業ですが、LoRAではこの巨大な行列を直接いじるのではなく、二つの小さな行列(低ランク行列)に分解して計算を行います。

これにより、学習パラメータ数を1/10,000程度まで削減できる場合もあり、GPUメモリ消費や計算負荷を抑えられます。

LoRAのメリット

LoRAのメリットは以下の通りです。

- 計算リソースを大幅に削減可能

- ストレージ容量の節約が可能

- 学習スピードを高速化が可能

- カタストロフィック忘却の抑制が可能

- ポータビリティと切り替えの容易さがある

それぞれ詳しく解説します。

計算リソースを大幅に削減可能

LoRAの最大のメリットは、学習に必要な計算リソースを大幅に抑えられる点です。

モデル全体の重みを更新する必要がないため、ビデオメモリの消費量が少なく、高性能な専用GPUを用意しなくても学習を進められます。

その結果、個人向けの一般的なGPU環境でも十分に実行可能であり、個人開発者や小規模チームでも導入しやすい手法といえます。

ストレージ容量の節約が可能

学習によって生成されるLoRAファイルは、ベースモデルに比べて非常に軽量なのが特徴です。

ベースモデルが数GBから数十GBある場合でも、LoRAファイルは数MBから数百MB程度で収まることが多いため、多様なバリエーションを保存してもストレージを圧迫せず、配布や共有もスムーズに行えます。

学習スピードを高速化が可能

更新するパラメータ数が圧倒的に少ないため、学習にかかる時間を短縮することが可能です。

例えば、フルファインチューニングでは数日かかるような学習内容でも、LoRAであれば数時間、条件によっては数十分で完了することもあります。

このように、試行錯誤のサイクルを高速で回せるため、短期間で質の高いモデルを作成できるのが大きなメリットです。

カタストロフィック忘却の抑制が可能

AIモデルが新しいことを学ぶ際、以前に学んだ知識を失ってしまう現象を「カタストロフィック忘却」と呼びます。

LoRAは元のモデルの重みを変更せずに凍結したまま学習を行うため、ベースモデルが元々持っている汎用的な知識や能力を損なうリスクを抑制することが可能です。

ポータビリティと切り替えの容易さがある

LoRAは「アダプタ」として機能するため、ベースモデルさえあれば簡単に脱着が可能です。

例えば、画像生成において「特定の画風のLoRA」と「特定のキャラクターのLoRA」を瞬時に切り替えたり、複数のLoRAを組み合わせて同時に適用したりすることも容易です。

LoRAのデメリット

LoRAのデメリットは以下の通りです。

- 表現力の限界がある

- ハイパーパラメータ設定が難しい

- 推論時のオーバーヘッドがある

- ベースモデルへの依存性がある

それぞれ詳しく説明します。

表現力の限界がある

パラメータ数を大幅に削減しているため、モデル全体の重みを更新する手法に比べると、複雑な概念や膨大な新しい知識を完全に習得させる能力には限界があります。

例えば、大幅な挙動変更や、全く新しい概念を一から教え込むような用途には、フルファインチューニングの方が適している場合も多いです。

ハイパーパラメータ設定が難しい

LoRAの学習には「Rank(ランク)」や「Alpha(アルファ)」といった、LoRA特有のハイパーパラメータが存在します。

これらの値が適切でないと、学習不足で効果が出なかったり、逆に「過学習」が起きて出力が崩れたりします。設定によって学習結果が大きく左右されるため、最適な値を見つけるには一定の知識と経験が求められます。

そのため、実運用ではエンジニアが複数の設定を試しながら調整するなど、ある程度の試行錯誤が前提となります。

推論時のオーバーヘッドがある

推論を行う際、ベースモデルにLoRAの重みを計算して加算するプロセスが発生するため、理論上は純粋なシングルモデルに比べて、読み込み時や計算時にわずかなリソース消費や遅延が生じます。

多重にLoRAを適用する場合はパフォーマンスへの影響を考慮する必要がありますが、現在のツールでは最適化が進んでいるため体感できるほどの差はないことがほとんどです。

ベースモデルへの依存性がある

LoRAは特定のベースモデルを前提に学習されるため、異なる構造を持つモデルには流用できません。

例えば、SD 1.5系で作成したLoRAをSDXL系で使用することは不可能です。

また、ベースモデルのアップデートや変更があった場合、LoRAもそれに合わせて再学習が必要になる可能性があるため、運用時にはベースモデルのバージョン管理も重要になります。

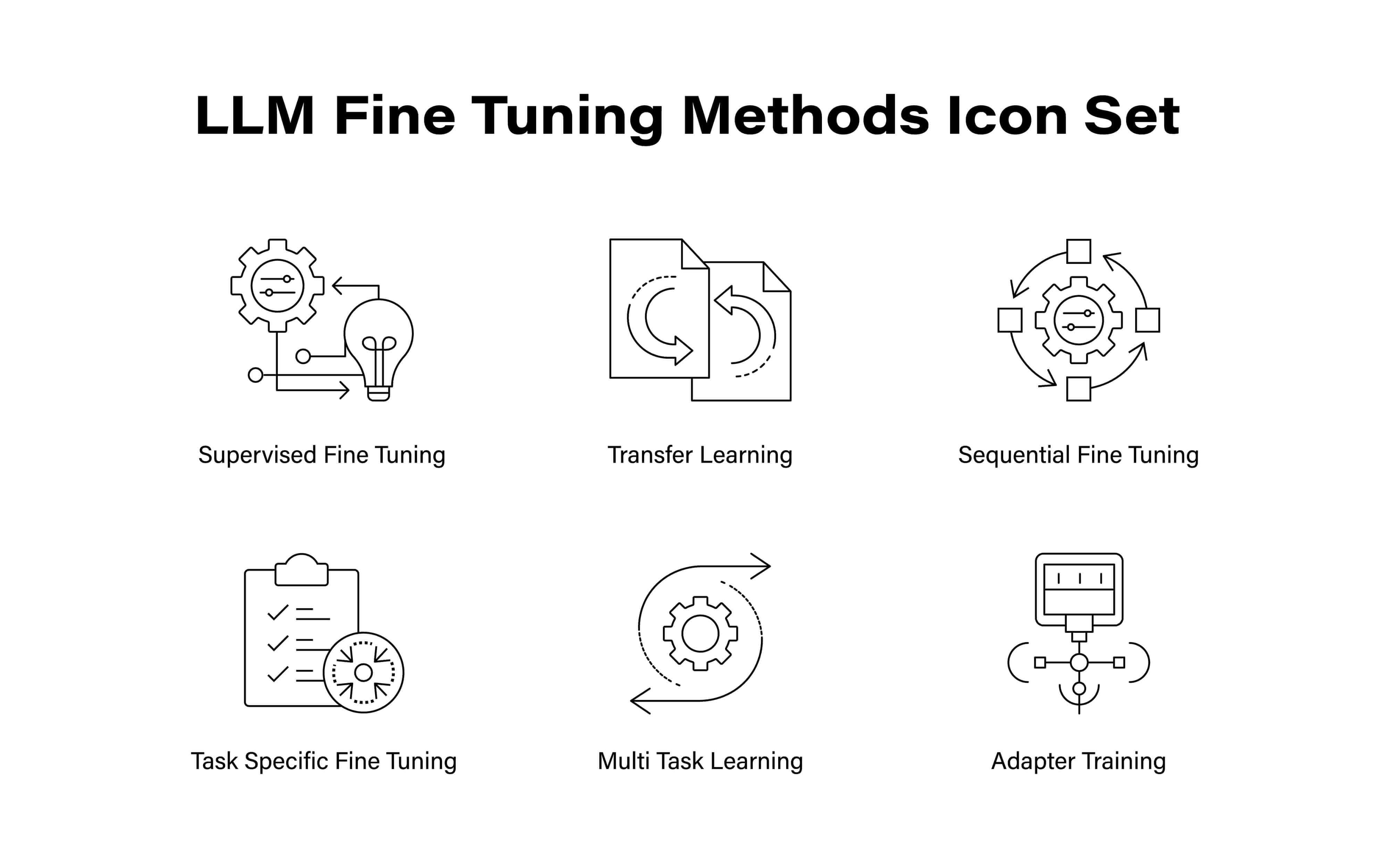

LoRAとファインチューニングの違い

LoRAと従来のフルファインチューニングの違いは、「モデルのどの部分を書き換えるか」というアプローチの差にあります。

ファインチューニングは、既存モデルの重み全体を更新し、新しいタスクや用途に最適化する手法です。

常に高い精度が期待できますが、その分、膨大な計算コストや学習時間、保存容量を必要とします。

一方、LoRAはベースモデルの重みを固定したまま、追加した低ランク行列のみを学習します。

この手法により、学習に必要なメモリを劇的に抑えつつ、フルファインチューニングに匹敵するカスタマイズ性能を実現することが可能です。

用途とリソースに応じて、両者を使い分けることが重要で、大規模な性能変更や独自モデルの構築が目的であればファインチューニング、特定の表現・スタイル・用途を効率よく追加したい場合にはLoRAが適しています。

LoRAの作成手順

LoRAの作成手順は以下の通りです。

- ベースモデルと学習用データを準備する

- LoRA専用パラメータ(rとα)を設定する

- PEFTライブラリでLoRA層を挿入する

- 学習を実行する

- アダプタを保存し推論テストを行う

それぞれ詳しく解説します。

ベースモデルと学習用データを準備する

まずは学習の土台となる「ベースモデル」を選定します。

次に、学習の核となるデータを20枚〜100枚程度用意します。

画像生成であれば、対象のポーズや角度、背景が多様であるほど、汎用性の高いLoRAが完成するため、データの質が重要になります。

また、データ一つひとつに「キャプション」と呼ばれる説明文を付ける作業も、学習の精度を左右する重要な要素のひとつです。

LoRA専用パラメータ(rとα)を設定する

学習の際には、LoRA独自の重要パラメータである「Rank(r)」と「Alpha(α)」を決定します。Rankは追加する行列の複雑さを表し、数値を大きくすれば表現力が上がりますが、比例してファイル容量も増加します。

また、過学習や不安定な出力につながる場合もあるため、目的に応じた調整が必要です。

一般的には「Rank=8〜128」程度が推奨されており、Alphaはその学習結果をどの程度の強さでベースモデルに反映させるかを調整する役割を担います。

PEFTライブラリでLoRA層を挿入する

開発環境では、Hugging Faceが提供する「PEFT(Parameter-Efficient Fine-Tuning)」ライブラリを活用するのが主流です。

このライブラリを使うことで、巨大なモデルの中にLoRA用の軽量な層を自動的に挿入できます。

GUIツールを利用する場合も、内部ではこのPEFTの仕組みが動いており、ユーザーは複雑なコードを書くことなく、効率的な学習環境を構築できるようになっています。

学習を実行する

設定が完了したら、いよいよ学習を実行します。

LoRAは学習が高速なため、途中経過を確認しながら調整することができます。学習中は「Loss(損失率)」という指標を監視し、AIがどれだけ正確にデータを理解できているかを確認し、生成結果に応じてパラメータやデータを見直します。

また、データの丸暗記などの過学習を防ぐために、一定のサイクルごとに「エポック」を区切り、複数の進捗段階でモデルを保存しておくことも大切です。

アダプタを保存し推論テストを行う

学習が終わると、軽量なLoRAファイルが生成されます。

完成したファイルを画像生成ツールなどで読み込み、実際にプロンプトを入力してテストを行います。狙い通りの特徴が出ているか、他の要素と競合して画像が崩れていないかを確認します。

もし納得がいかない場合は、学習データの選別やパラメータの微調整を行い、再度学習を回し、より理想に近いモデルへと磨き上げていきます。

LoRAの導入方法

LoRAの導入方法は以下の通りです。

- ベースモデルをインストールする

- LoRAファイルをダウンロードする

- ファイルを専用フォルダへ配置する

- ツール上で適用したいLoRAを選択する

- 強度の調整をする

それぞれ解説します。

ベースモデルをインストールする

LoRAを機能させるためには、そのLoRAが前提としている「ベースモデル」が環境にインストールされている必要があります。

例えば、SDXL向けに作られたLoRAは、SD 1.5の環境では動作しないため、目的のLoRAがどのバージョンを基に開発されたものかを確認し、適切なチェックポイントファイルをあらかじめ用意しておきましょう。

LoRAファイルをダウンロードする

CivitaiやHugging Faceなどといった世界中のクリエイターがモデルを共有するプラットフォームから、目的のLoRAファイルを探しましょう。

ファイル形式は、ウイルス混入のリスクが低く、安全に読み込める形式として普及している「.safetensors」が主流です。

また、ダウンロード時には、そのLoRAがどのベースモデルを前提に学習されているかを必ず確認しましょう。

Stable Diffusion 1.5向けなのか、SDXL向けなのかを見極めておかないと、正しく読み込めなかったり、期待した出力が得られないことがあります。

ファイルを専用フォルダへ配置する

入手したLoRAファイルは、生成ツールが認識できる特定のディレクトリへ移動させます。

例えば、最も普及している「Stable Diffusion WebUI(AUTOMATIC1111)」の場合、LoRAはインストール先にある「models/Lora」フォルダ に保存します。

LoRAが増えてくると管理が大変になりますが、このフォルダ内には自由にサブフォルダを作成できます。

そのため、「人物」「背景」「画風」といったカテゴリごとに整理しておくことで、生成時に迷うことなく目的のアダプタを呼び出せるようになり、作業時のストレスが軽減されます。

ツール上で適用したいLoRAを選択する

LoRAファイルの配置が完了したら、生成ツールのインターフェース上でLoRAを読み込みます。

Stable Diffusion WebUI(AUTOMATIC1111)を使用している場合は、「Lora」タブを開き、リフレッシュボタンを押すことで、配置したLoRAが一覧に表示されます。

使用したいLoRAをクリックすると、プロンプト入力欄に「lora:ファイル名:1.0」という形式のタグが自動で挿入されます。この数値はLoRAの適用強度を表す重みで、値を調整することで影響の強さをコントロールできます。

このタグがプロンプトに含まれている間、ベースモデルの出力にLoRAの学習内容が反映されるため、画風やキャラクターの特徴などに変化が現れます。

ただし、リアルタイムで統合されるというよりも、生成処理の際に重みが適用される仕組みである点には注意が必要です。

強度の調整をする

プロンプト内のタグにある数値(デフォルトの1.0)を書き換えることで、効果の濃淡を調整することが可能です。

例えば、「0.7」に設定すればベースモデルの良さを活かした控えめな適用になり、「1.2」に上げればLoRAの特徴をより強く押し出すことができます。

複数のLoRAを同時に呼び出し、それぞれの数値を「0.4と0.6」のように細かくブレンドすることで、単一のモデルでは到底不可能な、唯一無二の表現を作り出すことができます。

【業界別】LoRAの活用事例

ここでは、LoRAの活用事例を業界別に3つご紹介します。

エンタメ業界:キャラクターや人物モデルの生成

アニメ制作やゲーム開発の現場において、LoRAは「ビジュアルの一貫性」を保つために活用されています。

特定のキャラクターデザインをLoRAとして学習させることで、どんなに複雑な構図やポーズであっても、顔の造作や衣装の細部を崩さずに生成し続けることが可能になります。

これにより、膨大な手作業が必要だった設定資料や絵コンテの作成工程の効率化が実現されています。

医療業界:合成患者データを生成してAI診断モデルの精度評価に利用

プライバシー保護とデータの希少性が課題となる医療分野では、LoRAを用いた「合成データ」の活用に注目が集まっています。

特定の疾患の特徴をLoRAで学習し、実在しない患者の症例画像を生成することで、個人情報を一切侵害することなく診断AIのトレーニングや精度検証に活用されています。

アパレル業界:商品画像から着用イメージへのスタイル変換

ファッションビジネスでは、LoRAが「撮影コストの概念」を変えつつあります。

新作の服のデザインをLoRA化すれば、実写のようなモデル画像にその服を完璧に着せ替えることができます。

モデルのポーズ、人種、体型、ロケーションを自由に変更しながら、商品の魅力を最大限に引き出すビジュアルを瞬時に大量生産できるため、ECサイトの運営に役立てられています。

LoRAを利用する際の注意点

LoRAを利用する際の注意点は、以下の点に注意が必要です。

- 著作権への配慮

- 商用利用へのリスクマネジメント

それぞれ詳しく解説します。

著作権への配慮

LoRAは特定の作風や人物の特徴を正確に再現できてしまうため、学習データの取り扱いには細心の注意が必要です。

例えば、他者の著作物を無断で学習させ、その権利を侵害するような形でモデルを公開・配布することは、法的なトラブルに発展するリスクがあります。

そのため、権利関係がクリアなデータを使用する、あるいは私的利用の範囲に留めるといったモラルある運用が求められます。

商用利用へのリスクマネジメント

LoRAをビジネスに活用する際は、使用するLoRA自体の規約はもちろん、その土台となっているベースモデルのライセンス(商用利用の可否など)をすべてクリアしていなければなりません。

生成されたコンテンツを安心してビジネスに投入するためには、配布元が提示する利用規約を徹底的に確認しておく必要があります。

まとめ

LoRAは、ハイスペックなPC環境がなくても「自分の好きな画風」や「特定のキャラクター」「専門的な知識」をAIに効率よく学習させることができる、非常に自由度の高い技術です。

従来の学習手法に比べて圧倒的に軽量で扱いやすいため、個人での創作活動や、特定の用途に特化したAIモデルの構築において、今後さらに重要性が増していくことは間違いありません。

もし、AIスキルをプロの現場で試してみたい、あるいはキャリアへと繋げたいと考えているなら、AI・データサイエンス特化型エージェントサービス「BIGDATA NAVI」をチェックしてみてください。

AIを仕事にするためのキャリアノウハウ、機械学習・AIに関するTopics、フリーランス向けお役立ち情報を投稿します。

フリーランス求人を探す

フリーランス求人を探す